STORIA DELL'INFORMATICA

Nell’informatica potrebbe sembrare paradossale usare il termine “storia”, trattandosi di un settore in cui l’innovazione la fa da padrone e un semestre è un intervallo temporale enorme. Eppure la "storia" di questa grande rivoluzione si sta scrivendo proprio in questi anni e sarebbe un errore non prestargli la dovuta attenzione. Potremmo definirla una STORIA SENZA FINE...

Partiamo con una idea semplice chiedendoci, qual'è la differenza tra CALCOLATORE [computer] e CALCOLATRICE?!

La differenza fondamentale tra una calcolatrice e un calcolatore è che:

– un calcolatore può essere programmato in modo tale da consentire al programma di eseguire operazioni diverse a seconda dei risultati intermedi ottenuti

– le calcolatrici sono in grado di svolgere solo funzioni specifiche (somma, radice quadrata, ...).

La storia dell'informatica, infatti, inizia con l’abaco [antenato della calcolatrice] nel 2000 a.C.

Le macchine per calcolare poi non hanno subito per migliaia di anni particolari modifiche o innovazioni specifiche. Solo nel '600 la tecnica raggiunse un livello tale da permettere la costruzione di antenati delle odierne calcolatrici.

Partiamo con una idea semplice chiedendoci, qual'è la differenza tra CALCOLATORE [computer] e CALCOLATRICE?!

La differenza fondamentale tra una calcolatrice e un calcolatore è che:

– un calcolatore può essere programmato in modo tale da consentire al programma di eseguire operazioni diverse a seconda dei risultati intermedi ottenuti

– le calcolatrici sono in grado di svolgere solo funzioni specifiche (somma, radice quadrata, ...).

La storia dell'informatica, infatti, inizia con l’abaco [antenato della calcolatrice] nel 2000 a.C.

Le macchine per calcolare poi non hanno subito per migliaia di anni particolari modifiche o innovazioni specifiche. Solo nel '600 la tecnica raggiunse un livello tale da permettere la costruzione di antenati delle odierne calcolatrici.

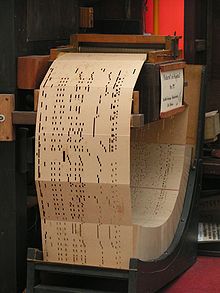

Le macchine calcolatrici non si diffusero a causa della delicatezza dei loro meccanismi. Solo agli inizi dell'800 conobbero una diffusione, specialmente in ambito bancario e commerciale (sono di quest'epoca i primi registratori di cassa, ad esempio) ad opera di Pascal e Leibnitz; il primo calcolatore meccanico automatico utilizzava schede perforate e fu realizzato da Sir Charles Babbage.

Nel 1924 Hollerith fondò la International Business Machine (IBM) e costruì, negli USA, i primi calcolatori a schede perforate per il censimento periodico della popolazione, il cui tempo si ridusse drasticamente da molti anni a pochi mesi.

Dopo il 1920 la macchina di calcolo diventa una qualsiasi macchina in grado di eseguire il lavoro, un “computer” (inteso come persona che esegue calcoli), in base alla tesi di Church-Turing:

"Un metodo matematico è efficace se può essere descritto da una lista di istruzioni eseguibili con carta e penna da un impiegato non ingenuo ma comunque privo di intuito".

Nel 1936 il logico inglese Alan Turing definisce il modello del calcolatore moderno, la cosiddetta 'macchina di Turing'.

Essa è in grado di eseguire operazioni elementari secondo uno schema di calcolo che consente di risolvere ogni tipo di problema di logica in un numero finito di passi: se un problema è intuitivamente calcolabile, allora esisterà una macchina di Turing [un computer] in grado di risolverlo.

Non ne verranno costruiti esemplari funzionanti, ma la sua idea costituirà la base dell'architettura

dei futuri computer. Il concetto della macchina programmabile fu ripreso da Konrad Zuse negli anni '30. Realizzò un calcolatore programmabile, elementi meccanici in grado di essere attivi o spenti; questo segnò il primo calcolatore che utilizzasse la base 2 [codice binario] invece della base 10 [sequenza dei numeri comunemente utilizzati].

Il lavoro di Zuse fu però sostanzialmente ignorato dalla comunità scientifica di allora, perchè il governo nazista rifiutò di sovvenzionare la loro realizzazione, perchè secondo i calcoli del Reich, avrebbe richiesto più tempo di quello che il governo tedesco contava di impiegare prima della fine della guerra...

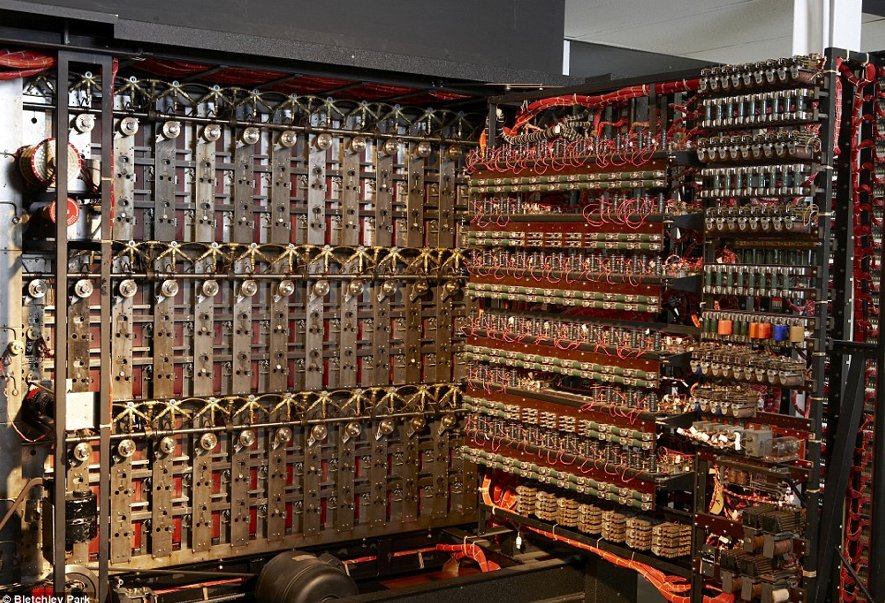

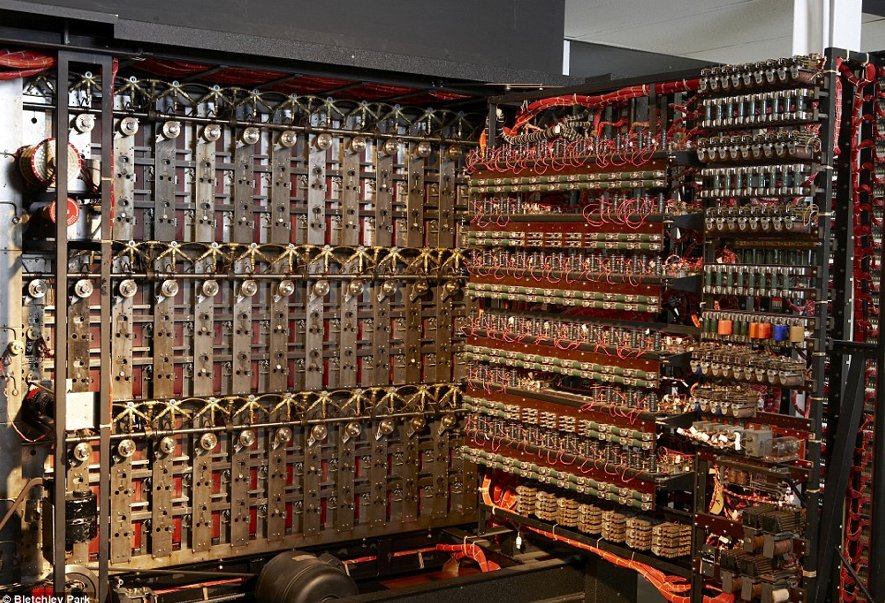

Gli Alleati, invece, non avevano sottovalutato l'importanza delle macchine per il calcolo automatico, infatti durante la guerra venne costruito uno dei primi veri computer nominato Colosso, dedicato alla decifrazione proprio dei messaggi nazisti intercettati, codificati con una macchina chiamata Enigma.

Alla fine della guerra Churchill ordinò la distruzione di tutti i Colossi in frammenti non più grandi di una mano. Venne creato l’ENIAC nel 1946, primo esemplare di calcolatore elettronico e programmabile:

• Costituito da 18.000 valvole termoioniche, collegate da 500.000 contatti saldati manualmente e 1.500 relé

• dissipava un calore di circa 200 Kilowatt

• occupava una stanza di 180 m2

• pesava 30 tonnellate.

Il 1955 vede la nascita di IBM 702: la prima macchina commerciale completamente costruita con transistor e messa sul mercato da IBM. Dal 1956 fu introdotto il FORTRAN, primo

linguaggio di programmazione ad alto livello, a cui seguirono LISP, COBOL, ALGOL e BASIC.

Nel 1958 fu costruito il primo circuito integrato e nel 1960 apparvero i primi chip al silicio.

Agli inizi i calcolatori erano enormi, costosissimi (e quindi appannaggio esclusivo delle grandi organizzazioni) e complicati da usare e programmare. Con l’evoluzione dell’elettronica e la comparsa dei circuiti integrati dagli anni ‘60 è aumentata la diffusione dell’informatica, sino all’esplosione degli anni ‘80 dovuta all’introduzione del PC.

Nel 1969 viene disegnata una semplice combinazione di un processore e di una unità di calcolo (la prima CPU), che sarà poi effettivamente realizzata dalla Intel, il processore Intel4004 a 4 bit, che diede inizio alla rivoluzione elettronica; in un unico chip era contenuta tutta la potenza di calcolo dell’ENIAC.

Nel 1975 comparve il primo microcomputer, l’Altair, per il quale Bill Gates (allora ragazzino) scrisse

l’interprete BASIC.

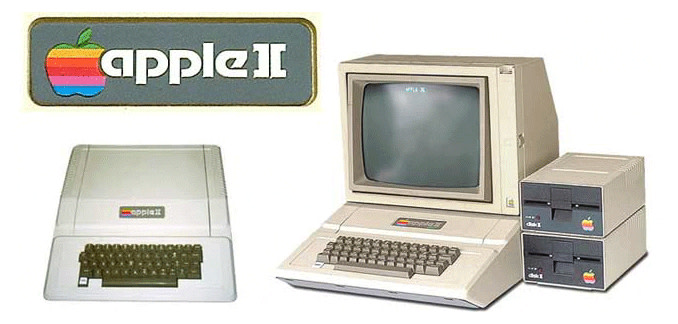

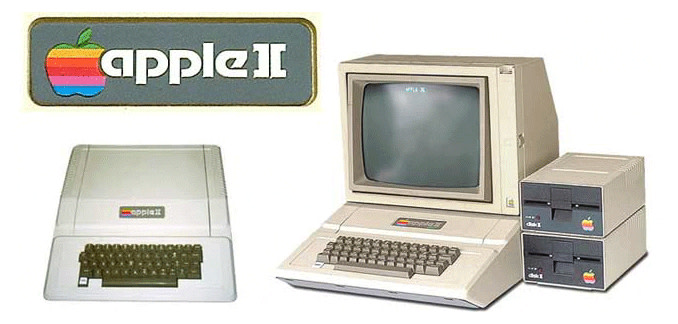

Nel 1977 Steve Jobs introdusse il primo PC Apple,APPLE II, il primo personal computer, con programmi di videoscrittura, fogli di calcolo, giochi e tanto altro, con un notevole impatto sul mercato; fino a quel momento gli elaboratori erano utilizzati soltanto da aziende e organismi governativi, e avevano

prezzi esorbitanti.

Ma solo nel 1981 apparve il PC IBM, il personal-computer per antonomasia, con un’architettura non coperta da brevetto: ciò ne consentì la cosiddetta “clonazione” ed enorme diffusione, con la creazione di un mercato hardware e software da miliardi di dollari (quello dei cosiddetti PC IBM compatibili e dei relativi programmi di base - MsDos, Windows - ed applicativi) che neanche il produttore seppe sino in fondo prevedere...

Nel 1984 viene annunciato dalla Apple il personal computer Macintosh; si tratta una macchina

interamente grafica, dal prezzo abbordabile. Si verificheranno continue dispute legali tra Microsoft ed Apple a causa dell’eccessiva somiglianza di Windows e Macintosh.

Nel futuro vedo un computer su ogni scrivania e uno in ogni casa. Bill Gates [1975]

fonte: Prof. Crescenzio Gallo - CONCETTI DI BASE

https://aforismi.meglio.it/frasi-film.htm?n=Steve+Jobs&pag=2

E.S.D. Eletronic Systems Design - Graziano Pravadelli